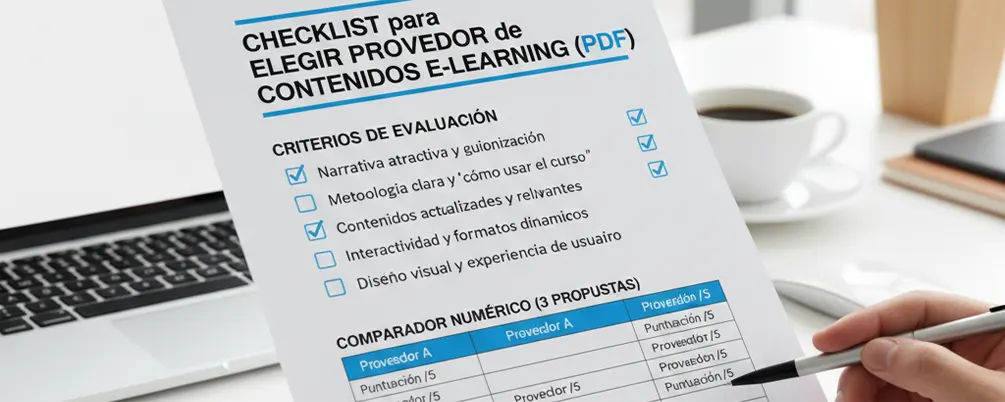

Esta guía práctica sirve para evaluar proveedores de contenidos educativos (no plataformas). Está pensada para evitar experiencias como las que yo sufrí: cursos chatos y aburridos, sin narrativa, sin explicar cómo usar el curso y con contenidos no actualizados, que terminan en abandono. Aquí esos dolores se convierten en criterios verificables y en un comparador numérico de tres propuestas.

Tabla de Contenidos

1. Qué evalúa un buen comprador de contenidos (no plataforma)

No compras software; compras experiencias de aprendizaje que deben guiar, motivar y demostrar logro. Si el alumno se siente abandonado, ni activa ni finaliza.

Por qué importa: La percepción del alumno impacta activación, progreso y finalización.

Cómo verificar: Solicita un módulo de muestra y evalúalo con una rúbrica de experiencia: onboarding claro, ritmo, variedad de formatos, feedback útil y cierre con recap. Recoge comentarios de 5–10 usuarios.

FP/SEPE y sectores regulados: RA → CE → Evidencias

Por qué importa: La trazabilidad permite defender calificaciones y auditar.

Cómo verificar: Pide una matriz RA→CE→Evidencias real (anonimizada) y el mapeo de preguntas/actividades a cada CE.

Entrega en tu entorno de destino

Por qué importa: Las demos genéricas ocultan incompatibilidades.

Cómo verificar: Exige un piloto con usuarios reales y un informe con capturas y logs.

2. SCORM/xAPI (seguimiento y compatibilidad)

SCORM/xAPI es el “idioma” que hace posible recordar avances y registrar resultados. Sin bookmarking fiable, el alumno vuelve y no sabe por dónde seguir; suele abandonar.

Por qué importa: Afecta reanudación, notas, reportes y cumplimiento.

Cómo verificar:

-

Paquete de muestra SCORM 1.2/2004 (3rd) con cmi.suspend_data y bookmarking.

-

Estados completed/passed/failed/incomplete correctos.

-

Interacciones por ítem exportables (CSV/API).

-

Si procede, xAPI con statements de ejemplo y documentación técnica.

-

Prueba controlada en tu entorno con registro de resultados.

3. Accesibilidad (WCAG 2.1 AA y PDF/UA)

Fuentes pequeñas, gráficos sin alt-text y vídeos sin subtítulos excluyen a personas y arruinan la experiencia.

Por qué importa: Es inclusión, cumplimiento y calidad.

Cómo verificar:

-

Navegación con teclado (foco visible, orden lógico).

-

Contraste ≥ 4.5:1 y tamaño de fuente legible.

-

Subtítulos .vtt, transcripciones y audio-descripción cuando proceda.

-

Anexos conformes a PDF/UA.

-

Informe WCAG con hallazgos y correcciones aplicadas.

«Sí” con evidencia (captura, paquete, informe). Sin evidencia, el “Sí” no cuenta.

4. Diseño instruccional (narrativa, microlearning, feedback)

El diseño instruccional sirve para que los cursos eficaces cuentan una historia que engancha, alternan formatos (vídeo, infografías, actividades) y ofrecen feedback específico. Lo contrario se percibe chato y sin narrativa, como empezar de cero en cada módulo.

Por qué importa: Mejora retención y transferencia.

Cómo verificar:

-

Storyboard con hilo (inicio–tensión–resolución) y recap al cierre.

-

Actividad cada 5–7 min con feedback útil (no solo “correcto/incorrecto”).

-

Infografías y resúmenes descargables que eviten la lectura plana de un texto locutado.

5. Banco de preguntas y GIFT/CSV (entornos tipo Moodle)

Un banco bien diseñado permite variedad, aleatorización y análisis. Sin ello, se repiten preguntas y la evaluación pierde valor.

Por qué importa: Asegura validez y dificulta la memorización mecánica.

Cómo verificar:

-

Etiquetas por tema, dificultad y CE.

-

Import/Export en GIFT/CSV.

-

Análisis de ítems (discriminación, dificultad) y versionado con histórico de cambios.

6. Calificador por criterios (RA→CE) para FP/SEPE

Pasar de RA a CE y de ahí a evidencias (rúbricas, actividades, preguntas) añade objetividad y claridad.

Por qué importa: Permite auditar y mejorar lo que se enseña.

Cómo verificar: Matriz RA→CE→Evidencias, rúbricas por criterio y mapeo de preguntas/actividades a CE; export de evidencias con traza de quién evaluó qué y cuándo.

7. QA y entregables (changelog, fuentes, hoja de pruebas)

Un proveedor serio entrega calidad verificable y deja todo listo para mantener y actualizar. No sirve el “se hizo una vez y se quedó así”; eso es contenido no actualizado.

Por qué importa: Evita deuda didáctica y técnica.

Cómo verificar:

-

Plan de QA (didáctico + funcional + accesibilidad) y rondas incluidas.

-

Changelog por versión con lo que cambió y por qué.

-

Inventario de entregables: paquete SCORM/xAPI, fuentes (Storyline/Captivate), medios optimizados, subtítulos/transcripciones y licencias.

-

Hoja de pruebas en tu entorno con resultados del piloto y acciones correctivas.

Red flags (descarta o exige piloto)

-

Rechazo a probar en tu entorno con usuarios reales.

-

Sin evidencia de WCAG 2.1 AA o anexos sin PDF/UA.

-

Ausencia de matriz RA/CE y rúbricas.

-

Paquetes sin bookmarking ni estados correctos.

-

Entregables sin fuentes o sin control de versiones.

-

Solo muestran demo genérica y evitan evidencias.

Comparador rápido (3 propuestas, 10 criterios)

Decide con números, no con impresiones. Puntúa 0–10 y aplica estos pesos (ajústalos a tu caso):

-

Accesibilidad (WCAG/PDF/UA) 20%

-

Diseño instruccional 20%

-

SCORM/xAPI 15%

-

Calificador RA→CE 15%

-

Banco de preguntas (GIFT/CSV) 10%

-

QA y entregables 10%

-

Experiencia en tu entorno 5%

-

Plazos y capacidad 3%

-

Actualización y mantenibilidad 1%

-

Soporte de cambios menores 1%

El resultado (0–100) defiende tu elección ante cualquier comité.